Dla kogo jest kurs Data Engineer?

Kurs Data Engineer jest dla tych, którzy chcą wejść głębiej w świat danych i nauczyć się tworzyć solidne fundamenty pod zaawansowaną analitykę, AI i systemy Big Data.

Zapisz się, jeśli:

Czego nauczysz się na kursie Data Engineer?

Co otrzymasz w ramach kursu Data Engineer?

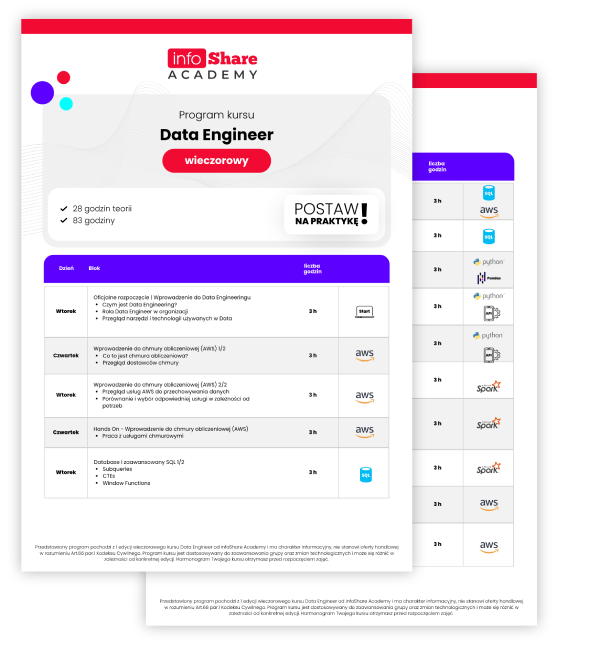

Zobacz program Data Engineer

Rozwiń wszystkie

Czego się nauczysz w tej sekcji?

Git: poznasz podstawy pracy z systemem kontroli wersji Git, nauczysz się, jak śledzić zmiany w projekcie, a także dowiesz się, jak korzystać z repozytoriów i współpracować z innymi programistami.

Python: nauczysz się podstaw składni języka Python, w tym zmiennych, pętli i funkcji.

SQL: wykonasz podstawowe operacje na bazach danych z użyciem SQL oraz zrozumiesz, jak projektować proste schematy bazy danych.

Czego się nauczysz w tej sekcji?

- Poznanie praktycznych zastosowań Dockera w pracy Data Engineera.

- Nauka konfiguracji, zarządzania obrazami i uruchamiania kontenerów dla aplikacji danych.

- Zrozumienie, jak Docker wspiera procesy integracji, przetwarzania i zarządzania danymi.

- Zapoznanie się z technikami skalowania i automatyzacji wdrożeń w środowiskach produkcyjnych.

- Poznanie narzędzi i metod monitorowania oraz optymalizacji infrastruktury danych.

Czego się nauczysz w tej sekcji?

- Nauka konfiguracji i zarządzania podstawowymi usługami AWS, takimi jak EC2 i S3.

- Poznanie zasad zarządzania dostępem i bezpieczeństwem w środowisku chmurowym.

- Zrozumienie, jak integrować różne usługi AWS w celu tworzenia kompleksowych rozwiązań.

- Nauka optymalizacji wydajności usług AWS oraz monitorowania zasobów.

- Poznanie metod konfiguracji sieci i storage w AWS.

- Zrozumienie podstaw zarządzania kosztami w AWS i optymalizacji zasobów chmurowych.

Czego się nauczysz w tej sekcji?

- Nauka budowania skomplikowanych zapytań SQL z wykorzystaniem funkcji okna i CTE.

- Poznanie zaawansowanych technik optymalizacji zapytań i indeksowania baz danych.

- Zrozumienie, jak projektować i implementować schematy baz danych dla różnych scenariuszy biznesowych.

- Nauka zarządzania dużymi zbiorami danych i optymalizacji ich przechowywania.

- Poznanie technik partycjonowania danych w bazach SQL.

- Zrozumienie, jak analizować i interpretować dane za pomocą zaawansowanych zapytań SQL.

Czego się nauczysz w tej sekcji?

- Nauka projektowania baz danych z wykorzystaniem modeli NoSQL.

- Poznanie podstaw pracy z DynamoDB, w tym konfiguracji i zarządzania bazami.

- Zrozumienie, jak skalować bazy NoSQL w zależności od potrzeb aplikacji.

- Nauka optymalizacji wydajności zapytań i operacji w bazach NoSQL.

- Poznanie różnic między modelami relacyjnymi a nierealacyjnymi i ich zastosowań.

- Zrozumienie, jak zarządzać danymi w środowiskach rozproszonych z wykorzystaniem NoSQL.

Czego się nauczysz w tej sekcji?

- Nauka korzystania z bibliotek Pandas, NumPy i Polars do przetwarzania dużych zbiorów danych.

- Poznanie zaawansowanych technik programowania w Pythonie, takich jak zarządzanie pamięcią i optymalizacja kodu.

- Zrozumienie, jak tworzyć skrypty Pythona do automatyzacji zadań związanych z przetwarzaniem danych.

- Nauka pracy z API do pobierania i integrowania danych z zewnętrznych źródeł.

- Nauka integracji różnych źródeł danych w aplikacjach Pythonowych.

- Poznanie narzędzi do monitorowania i optymalizacji wydajności aplikacji Pythonowych.

Czego się nauczysz w tej sekcji?

- Nauka podstaw pracy z RDD i DataFrame’ami w PySpark.

- Zrozumienie, jak działa Lazy evaluation i Transformations w PySpark.

- Nauka skalowania aplikacji PySpark w środowiskach rozproszonych.

- Poznanie technik zarządzania pamięcią i optymalizacji przetwarzania w PySpark.

- Zrozumienie podstaw równoległości i przetwarzania równoległego w PySpark.

- Nauka implementacji projektów Big Data z wykorzystaniem PySpark.

Czego się nauczysz w tej sekcji?

- Nauka konfiguracji i zarządzania klastrami Apache Kafka.

- Poznanie metod tworzenia i zarządzania topikami, producentami i konsumentami w Kafka.

- Zrozumienie, jak projektować systemy przetwarzania strumieniowego o wysokiej wydajności.

- Nauka monitorowania i diagnostyki wydajności systemów Kafka.

- Poznanie technik skalowania i zarządzania obciążeniem w środowiskach strumieniowych.

- Zrozumienie architektury rozproszonych systemów przetwarzania strumieniowego.

Czego się nauczysz w tej sekcji?

- Nauka projektowania procesów ETL do przetwarzania danych z różnych źródeł.

- Poznanie technik transformacji danych w celu uzyskania optymalnych rezultatów.

- Zrozumienie, jak automatyzować i monitorować procesy ETL w dużych organizacjach.

- Nauka implementacji narzędzi ETL w różnych środowiskach technologicznych.

- Poznanie metod walidacji i czyszczenia danych przed ich ładowaniem do baz danych.

- Zrozumienie, jak integrować procesy ETL z hurtowniami danych i jeziorami danych.

Czego się nauczysz w tej sekcji?

- Nauka projektowania i implementacji schematów hurtowni i jeziorze danych.

- Nauka integracji różnych źródeł danych z hurtowniami i jeziorami danych.

- Poznanie metod zarządzania hurtowniami i jeziorami danych w chmurze.

- Zrozumienie roli hurtowni i jezior danych w tworzeniu raportów i analiz biznesowych.

- Nauka optymalizacji przechowywania danych w hurtowniach i jeziorach dla lepszej wydajności.

Czego się nauczysz w tej sekcji?

- Nauka konfiguracji i uruchamiania środowiska Apache Airflow.

- Poznanie technik definiowania i zarządzania DAGs dla przepływów pracy.

- Zrozumienie, jak automatyzować złożone przepływy danych za pomocą Airflow.

- Nauka integracji Airflow z innymi narzędziami i systemami danych.

- Poznanie metod monitorowania i zarządzania przepływami pracy w Airflow.

- Zrozumienie, jak używać Airflow do zarządzania projektami danych w organizacji.

Czego się nauczysz w tej sekcji?

- Nauka efektywnego przetwarzania danych w środowisku Databricks.

- Poznanie metod tworzenia i wdrażania modeli uczenia maszynowego w Databricks.

- Zrozumienie, jak testować i walidować modele w chmurze z użyciem Databricks.

- Nauka integracji Databricks z innymi narzędziami analitycznymi i platformami danych.

- Poznanie narzędzi do współpracy zespołowej dostępnych w Databricks.

- Zrozumienie, jak zarządzać projektami danych w środowisku chmurowym Databricks.

Czego się nauczysz w tej sekcji?

- Nauka konfiguracji i zarządzania środowiskiem Snowflake.

- Poznanie kluczowych komponentów i architektury Snowflake.

- Zrozumienie, jak Snowflake oddziela przetwarzanie od przechowywania danych.

- Nauka zarządzania dużymi zbiorami danych w Snowflake.

- Poznanie metod czyszczenia i walidacji danych w Snowflake.

- Zrozumienie, jak korzystać z narzędzi analitycznych dostępnych w Snowflake.

Czego się nauczysz w tej sekcji?

- Nauka koncepcji i zasad działania modelu Data Mesh.

- Poznanie metod planowania i implementacji decentralizacji zarządzania danymi.

- Zrozumienie, jak definiować i zarządzać domenami danych w organizacji.

- Nauka utrzymywania spójności i jakości danych w rozproszonym modelu zarządzania.

- Poznanie technologii wspierających implementację Data Mesh.

- Zrozumienie wyzwań w implementacji Data Mesh i strategii ich rozwiązywania.

Technologie i narzędzia, które opanujesz na kursie Data Engineer

AWS

AWS S3

SQL

Kubernetes

Docker

Python

Pandas

NumPy

Polars

API

Hadoop

Spark

DynamoDB

Kafka

Amazon Redshift

Apache Airflow

Databricks

Snowflake

Opinie kursantów

Przeszkoliliśmy ponad 7 500 osób

Najczęściej wybierane formy finansowania

Zapytaj o kurs

Agnieszka Frąckiewicz

Customer Success Coordinator

agnieszka.frackiewicz@infoshareacademy.com(+48) 530 100 686

Najczęstsze pytania i odpowiedzi

Aby zapisać się na kurs możesz wypełnić formularz, wysłać maila bezpośrednio do opiekunki lub zadzwonić. W przypadku zgłoszenia się przez formularz otrzymasz od razu maila ze szczegółowym programem kursu oraz informacjami o kolejnych krokach.

Zajęcia na kursie odbywają się w soboty i niedziele od 8:00 do 11:00.

Obowiązkowym punktem rozpoczęcia kursu jest przerobienie preworku – są to materiały do samodzielnej nauki. Otrzymasz od nas wszystkie niezbędne materiały, linki oraz instrukcje, jak krok po kroku zainstalować programy i narzędzia, z których będziesz korzystać w trakcie kursu. Przykładając się do jego wykonania, zapewniasz sobie i reszcie grupy sprawny start w kursie i możliwość bezproblemowego rozpoczęcia nauki i pracy nad projektem. Z drugiej strony, w przypadku naszych kursów – bardzo intensywnych i napakowanych wiedzą, zlekceważenie preworku może skutkować późniejszym nawarstwieniem się zaległości, które będzie niezwykle trudno nadrobić w trakcie kursu.

Kurs jest dla Ciebie, jeśli lubisz analizować dane, masz zamiłowanie do matematyki, lubisz rozwiązywać skomplikowane problemy lub jesteś osobą z technicznym zacięciem. Dodatkowo niezbędne do rozpoczęcia nauki na kursie Data Engineer są: znajomość języka angielskiego na poziomie min. B1/B2, wykonanie preworku, który otrzymasz po zapisaniu się na kurs, wysoka motywacja, dyspozycyjność – czas na zajęcia, ale również naukę w domu.

Główną przewagą kursu nad studiami jest warsztatowa forma zajęć – wiedzę zdobytą na zajęciach teoretycznych kursanci wykorzystują od razu na zajęciach praktycznych. Zarówno zajęcia teoretyczne, jak i warsztaty prowadzą doświadczeni trenerzy – praktycy. W Akademii dbamy o to, aby program kursu był dopasowany do aktualnej sytuacji na rynku pracy. Kursy są krótsze niż studia, co z jednej strony wiąże się większym natężeniem zajęć i dostarczanej wiedzy, a z drugiej sprawia, że szybciej możesz rozpocząć swój rozwój w obszarze Data Science. Na koniec – na kursach panuje bardzo dobra atmosfera, kursanci wspierają się wzajemnie i są w stałym kontakcie ze sobą i z trenerami na komunikatorze wewnętrznym w czasie trwania zajęć.

Jeśli chodzi o samo uczestnictwo w kursach, to wiek nie jest ograniczeniem. Nasze kursy kończyli zarówno 18-latkowie, jak i osoby 50+. Należy jednak pamiętać, że karierę w branży IT zaczyna się od stażu albo od stanowiska juniora, co może wiązać się z otrzymywaniem niższego wynagrodzenia niż na obecnym miejscu pracy, jeśli ma się już kilkanaście lat doświadczenia. Warto wziąć to pod uwagę zanim podejmie się decyzję o przebranżowieniu.

Na rynku jest dostępnych wiele form finansowania kursów, szczegółowe informacje znajdziesz na naszej stronie Finansowanie.

Tak, zajęcia są nagrywane i można z nich korzystać, żeby utrwalać wiedzę z zajęć.

Oczywiście, po zaliczeniu kursu otrzymasz od nas doceniany na rynku certyfikat infoShare Academy z informacją o zakresie kursu i terminie, w jakim kurs się odbywał. Certyfikat podpisany jest przez CEO infoShare Academy oraz Trenera prowadzącego kurs. Otrzymasz go w formacie PDF, dzięki czemu łatwo podzielisz się informacją o zdobytych kwalifikacjach na LinkedIn z potencjalnymi, przyszłymi pracodawcami lub klientami.